多輸出決策樹回歸?

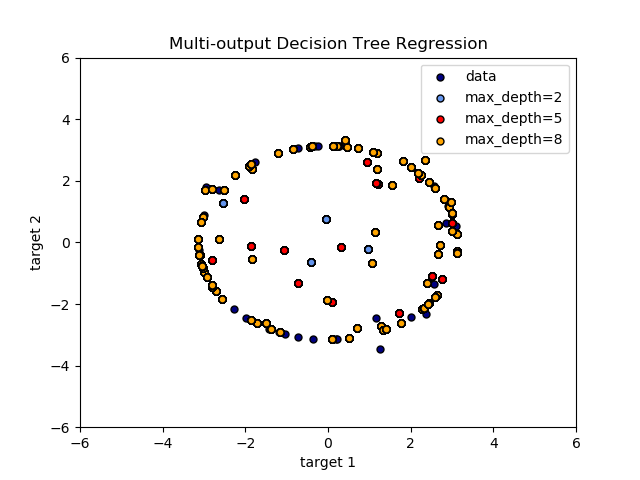

一個用決策樹展示多輸出回歸的例子。

決策樹用于同時預測給定單個特征的圓的噪聲x和y的觀測值。因此,它學習了近似圓的局部線性回歸。

我們可以看到,如果樹的最大深度(由參數max_depth控制)設置得太大,則決策樹學習訓練數據的細節太細,并從噪聲中學習,即過擬合。

print(__doc__)

import numpy as np

import matplotlib.pyplot as plt

from sklearn.tree import DecisionTreeRegressor

# Create a random dataset

rng = np.random.RandomState(1)

X = np.sort(200 * rng.rand(100, 1) - 100, axis=0)

y = np.array([np.pi * np.sin(X).ravel(), np.pi * np.cos(X).ravel()]).T

y[::5, :] += (0.5 - rng.rand(20, 2))

# Fit regression model

regr_1 = DecisionTreeRegressor(max_depth=2)

regr_2 = DecisionTreeRegressor(max_depth=5)

regr_3 = DecisionTreeRegressor(max_depth=8)

regr_1.fit(X, y)

regr_2.fit(X, y)

regr_3.fit(X, y)

# Predict

X_test = np.arange(-100.0, 100.0, 0.01)[:, np.newaxis]

y_1 = regr_1.predict(X_test)

y_2 = regr_2.predict(X_test)

y_3 = regr_3.predict(X_test)

# Plot the results

plt.figure()

s = 25

plt.scatter(y[:, 0], y[:, 1], c="navy", s=s,

edgecolor="black", label="data")

plt.scatter(y_1[:, 0], y_1[:, 1], c="cornflowerblue", s=s,

edgecolor="black", label="max_depth=2")

plt.scatter(y_2[:, 0], y_2[:, 1], c="red", s=s,

edgecolor="black", label="max_depth=5")

plt.scatter(y_3[:, 0], y_3[:, 1], c="orange", s=s,

edgecolor="black", label="max_depth=8")

plt.xlim([-6, 6])

plt.ylim([-6, 6])

plt.xlabel("target 1")

plt.ylabel("target 2")

plt.title("Multi-output Decision Tree Regression")

plt.legend(loc="best")

plt.show()

腳本的總運行時間:(0分0.415秒)

Download Python source code:plot_tree_regression_multioutput.py

Download Jupyter notebook:plot_tree_regression_multioutput.ipynb